همه فعالیت هایی که برای بهبود سئو سایت انجام میشود باید توسط ربات های گوگل ایندکس شود تا بر اساس اقدامات صورت گرفته تغییراتی در رتبه بندی سایت انجام گیرد(مطاله بیشتر: ایندکس چیست). در مقاله قبلی تعیین کردیم که چطور میتوان از طریق ساخت سایت مپ ربات های گوگل را به ایندکس کردن و اولیت بندی صفحات سایت هدایت کرد.(اگر نمیدانید چطور باید سایت مپ بسازید و ایندکس کردن صفحات سایت تان را تسریع بخشید حتما مقاله sitemap چیست را مطالعه کنید).

در این مقاله به شما توضیح میدهیم که چطور باید برای گوگل نحوه خزش در سایت تان را تعیین کنید. اگر ا مطالعه کل این مقاله همچنان سوالی در مورد این که فایل Robots.txt چیست و چطور یک فایل Robots عالی بسازیم باقی ماند میتوانید در بخش نظرات سوال تان را مطرح کنید.

فایل robot.txt چیست

در سئو حتما نام فایل robot txt را شنیده اید اما سوالی که مطرح میشود این است که فایل robots.txt چیست و چه کاربردی در سئو سایت دارد؟

فایل robots.txt قراردادی است برای جلوگیری از دسترسی خزنده های وب به تمام یا بخشی از یک وب سایت ساخته میشود. این یک فایل متنی با فرمت .txt است که برای SEO استفاده می شود و حاوی دستوراتی برای ربات های موتورهای جستجو است که صفحاتی را مشخص می کند که می توانند یا نمی توانند ایندکس شوند.

robots.txt برای فهرست کردن صفحات استفاده نمی شود، بلکه برای جلوگیری از خزش در آنها استفاده می شود. اگر صفحهای قبلاً ایندکس نشده بود، جلوگیری از خزیدن آن باعث میشود که هرگز ایندکس نشود. اما اگر صفحه ای قبلاً ایندکس شده باشد یا وب سایت دیگری به آن پیوند داده شود، robots.txt اجازه فهرست زدایی را به آن صفحه از سایت نمی دهد.

برای جلوگیری از ایندکس شدن یک صفحه در گوگل، باید از تگ noindex استفاده کنید اما اگر هدف شما این باشد که تعدا صفحات متعددی را به این وضعیت منتقل کنید نمیتوان از این تگ استفاده کرد. در این صورت ساخت robot.txt به کمک شما میاید و شما میتوانید ایندکس نشدن دسته ای از صفحات را به انجام برسانید.

بنابراین هدف اصلی فایل robots.txt مدیریت خزش ربات ها با ممنوع کردن خزش آن ها در صفحات معین میباشد.

اگر سئوکار هستید و میخواهید بیشتر با ابزارهای سئو آشنا شوید به شما پیشنهاد میکنیم یادگیری سرچ کنسول را جز برنامه های خود قرار دهید. اگر نمیدانید این ابزار چه قابلیت هایی دارد حتما مقاله سرچ کنسول گوگل چیست را مطالعه کنید.

نحوه کار فایل robot.txt

موتورهای جستجو دو وظیفه اصلی دارند: خزیدن در سایت ها برای کشف محتوا و فهرست بندی صفحات حاوی محتوا به طوری که بتواند بین کاربرانی که به دنبال اطلاعات هستند با بهترین رتبه بندی توزیع شود.

برای خزیدن در سایت ها موتورهای جستجو لینک ها را دنبال می کنند تا از یک سایت به سایت دیگر برسند، آنها میلیاردها لینک و وب سایت را می خزند. هنگامی که ربات موتور جستجو به یک وب سایت دسترسی پیدا می کند، به دنبال فایل robots.txt می گردد.

اگر فایل robot txt را پیدا کند، ربات ابتدا این فایل را قبل از ادامه مرور صفحه می خواند. اگر فایل robots.txt حاوی دستورالعملهایی برای منع فعالیت عامل کاربر نباشد یا اگر سایت فایل robots.txt نداشته باشد بدون هیچ گونه محدودیتی خزش در ساییت را انجام میدهد.

اهمیت ساخت robot.txt

شاید این سوال برای شما پیش آمده باشد که با وجود آن که فایل robot txt جلوی خزش یک سری از صفحات را میگیرد اما چه اهمیتی دارد که این فایل در سایت ما وجود داشته باشد؟ در واقع میتوان گفت مزایا فایل robot txt عبارتند از:

- از خزیدن محتوای تکراری خودداری میکند.

- جلوگیری از خزیدن موتور جستجو در صفحات بی اهمیت برای سئو.

- جلوگیری از ایندکس کردن تصاویر خاص توسط موتورهای جستجو در سایت.

- محل نقشه سایت را مشخص کنید.

اگر سایت شما شامل صفحاتی نیست که میخواهید دسترسی کاربر را کنترل کنید، ممکن است به فایل robots.txt نیاز نداشته باشید.

اگر میخواهید در کوتاهترنی زمان کار با ابزار سرچ کنسول را یاد بگیرید پیشنهاد میکنیم از آموزش سرچ کنسول مجتمع فنی آریا تهران نهایت بهره را ببرید. این دوره زیر نظر برترین اساتید سئو ترهان آموزش داده شده و شما میتوانید به خوبی با جزییات این ابزار آشنا شوید و برای بهبود سایت خود از آن استفاده کنید.

دانلود فایل robot.txt

برای دانلود فایل robot txt شما باتدا باید بدانید robots.txt را کجا قرار دهید. شما نمی دانید که آیا فایل robots.txt دارید یا نه؟

برای دسترسی و دانلود فایل robot txt باید دامنه سایت تان را تایپ کنید و سپس /robots.txt را در انتهای URL اضافه کنید. به عنوان مثال، فایل فایل robot txt را در انتهای دامنه “example.com” به صورت “https://www.example.com/robots.txt” قرار دهید.

اگر صفحه txt. نمایش داده نشد، این سایت صفحه robots.txt ندارد.

اگر robots.txt ندارید:

آیا به آن نیاز دارید؟ بررسی کنید که صفحات کم ارزشی که به آن نیاز دارند ندارید. مثال: سبد خرید، صفحات جستجوی موتور جستجوی داخلی شما و غیره.

اگر به آن نیاز دارید، فایل را مطابق دستورالعمل های ذکر شده در این مقاله ایجاد کنید.

اگر میخواهید بهترین استراتژی سئو برای سایت تان داشته باشید . از همان ابتدا برای بهبود رتبه صفحات سایت تان بهترین برنامه ریزی و نقشه راه را داشته باشید حتما مقاله تعیین استراتژی سئو تهران را مطالعه کنید. در ان مقاله با راهکار های کاربردی به شما کمک کردیم در کوتاهترین زمان بهترین وموثرترین استراتژی برای سئو سایت تان بچینید.

آموزش ساخت فایل robot.txt

در آموزش robot txt شما باید بتوانید اقدام به ساخت robot.txt کنید که در این قسمت از مقاله به صورت جامع آموزش ساخت فایل robot.txt را برای شما عزیزان قرار داده ایم.

یک فایل robots.txt از یک یا چند دستورالعمل تشکیل شده است. با توجه به فرمت این فایل می توانید تقریباً از هر ویرایشگر متنی برای ساخت robot.txt استفاده کنید. و

یرایشگر متن باید قادر به ایجاد فایل های متنی استاندارد ASCII یا UTF-8 باشد. از نرم افزار ورد استفاده نکنید، زیرا این برنامهها اغلب فایلها را در قالبی اختصاصی ذخیره میکنند و ممکن است کاراکترهای غیرمنتظرهای اضافه کنند که میتواند ربات خزندهها را گیج کند.

شما می توانید با استفاده از ویرایشگر متن ساده دلخواه، یک فایل robots.txt جدید ایجاد کنید. (به یاد داشته باشید، فقط از یک ویرایشگر متن ساده استفاده کنید.)

اگر قبلاً یک فایل robots.txt دارید، مطمئن شوید که متن آن را حذف کرده اید ( نه فایل). ابتدا، باید با برخی از دستورات استفاده شده در فایل robots.txt آشنا شوید.

دستورات ساخت فایل robot.txt عبارتند از:

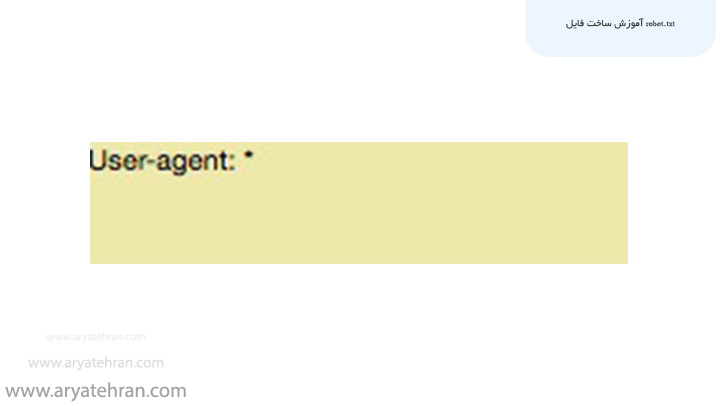

با تنظیم عبارت user-agent شروع کنید. ما آن را طوری تنظیم می کنیم که برای همه ربات های وب اعمال شود.

این کار را با استفاده از یک ستاره بعد از عبارت user-agent انجام دهید، مانند این:

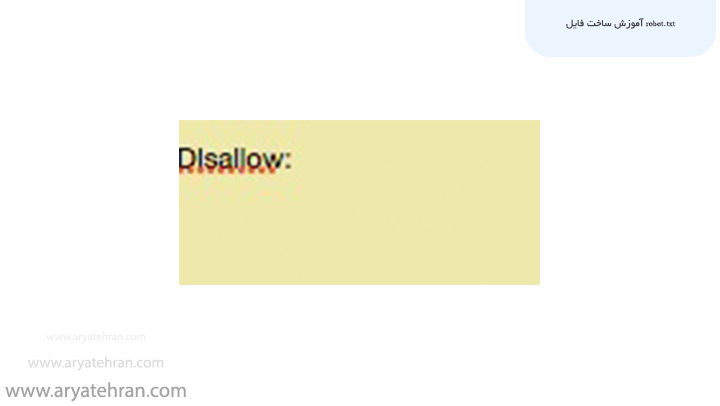

بعد، «Disallow:» را تایپ کنید اما بعد از آن چیزی تایپ نکنید.

از آنجایی که پس از Disallow چیزی وجود ندارد، ربات های وب هدایت می شوند تا کل سایت شما را بخزند. در حال حاضر، همه چیز در سایت شما یک بازی مجاز است.

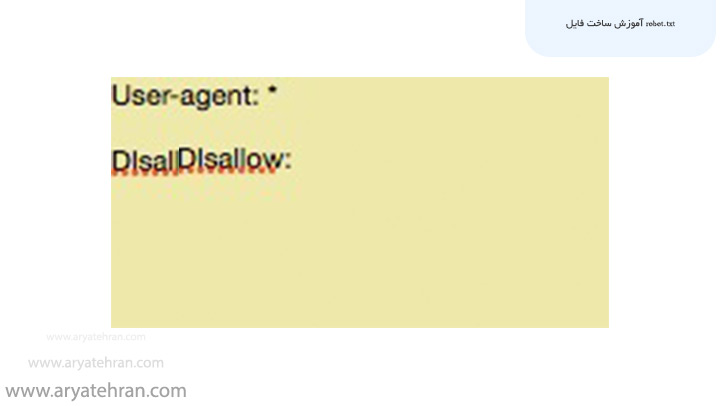

تا اینجا، فایل robots.txt شما باید به شکل زیر باشد:

این دستورات بسیار ساده به نظر می رسند، اما این دو خط در حال حاضر کارهای زیادی انجام می دهند.

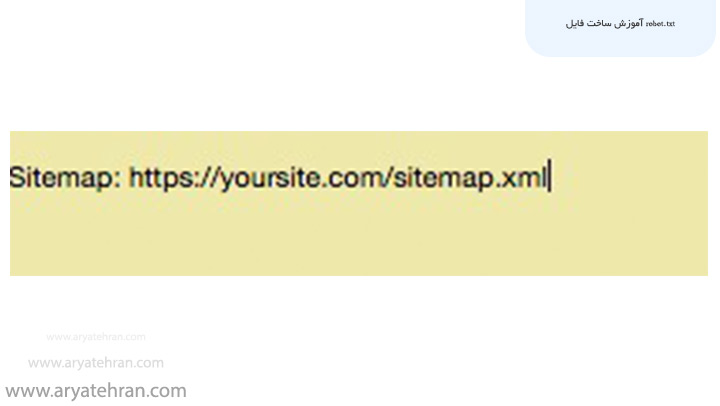

شما همچنین می توانید به نقشه سایت XML خود لینک دهید، اما این کار ضروری نیست. اگر می خواهید لینک به صفحه ای انجام دهیدمیتوانید مانند زیر این کار را انجام دهید:

حالا بیایید آن را به سطح بعدی ببریم و این فایل کوچک را به یک بهبود دهنده سئو تبدیل کنیم.

همان طور که گفته شد سرچ کنسول یکی از ابزار سئو سایت میباشد. اگر میخواهید با لیستی از ابزار های پرکاربرد سئو سایت آشنا شوید و از این ابزار ها برای بهبود رتبه سایت تان استفاده کنید پیشنهاد میکنیم حتما مقاله ابزار سئو سایت را مطالعه کنید.

نحوه بهینه سازی robots.txt برای سئو

سوالی که شما میتوانید در انتهای این بخش به آن پاسخ دهید این است که فایل robots.txt چیست و چه کاربردی در سئو سایت دارد.

نحوه بهینه سازی robots.txt برای سئو به محتوایی که در سایت خود دارید بستگی دارد. روش های مختلفی برای استفاده از robots.txt در سئو وجود دارد.

یکی از بهترین کاربردهای فایل robots.txt، به حداکثر رساندن خزش موتورهای جستجو با تاکید به آنها به خزیدن در قسمتهایی از سایت شما است که برای عموم نمایش داده نمیشوند.

به عنوان مثال، اگر از فایل robots.txt برای این سایت (neilpatel.com) بازدید کنید، خواهید دید که صفحه ورود (wp-admin) را disallows کرده است.

از آنجایی که آن صفحه فقط برای ورود به قسمت بک اند استفاده می شود منطقی نیست که ربات های موتور جستجو وقت خود را صرف خزیدن در آن تلف کنند. شما از این دستور برای سایت های وردپرسی نیز استفاده کنید.

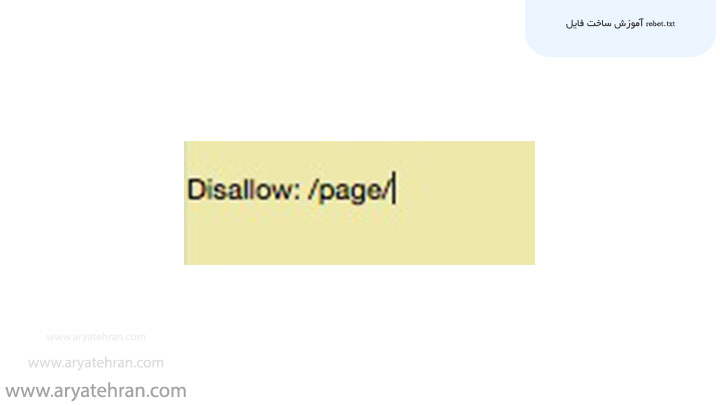

شما می توانید از دستور یا دستورات مشابهی برای جلوگیری از خزیدن ربات ها در صفحات خاص استفاده کنید. پس از disallow، بخشی از URL را که بعد از .com می آید وارد کنید و آن را بین دو / / قرار دهید.

بنابراین اگر می خواهید به یک ربات بگویید که در صفحه شما به آدرس http://yoursite.com/page/ نخزد، می توانید این را تایپ کنید:

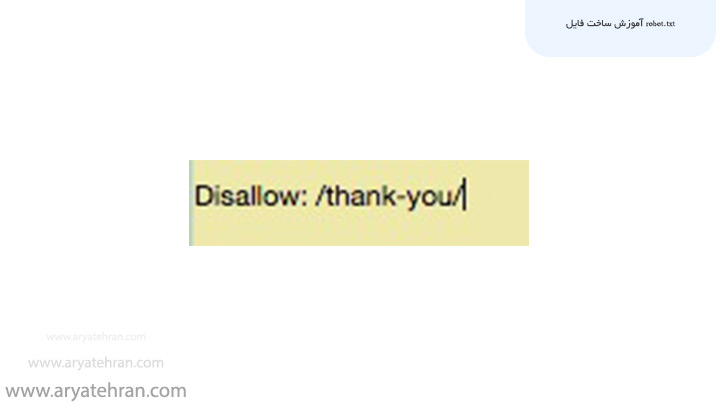

با مسدود کردن صفحات تشکر سایت خود، می توانید مطمئن شوید که ربات های گوگل آن صفحات را مورد خزش قرار نمیدهند.

بنابراین فرض کنید صفحه تشکر سایت در آدرس https://yoursite.com/thank-you/ وجود دارد که باید دستور زیر را اجرا کنید:

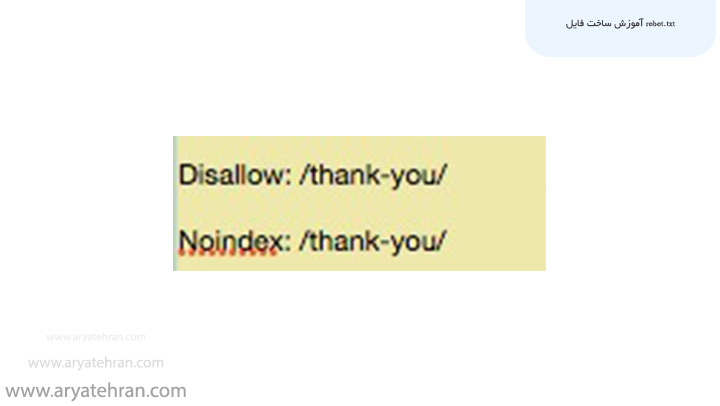

دو دستورالعمل دیگر وجود دارد که باید بدانید: noindex و nofollow.

آیا میدانید که چه زمانی از دستورالعمل disallow استفاده میکنیم؟ در واقع این دستور از ایندکس شدن صفحه جلوگیری نمی کند.

بنابراین از نظر تئوری، شما می توانید یک صفحه را disallow کنید، اما همچنان می تواند در فهرست ایندکس قرار گیرد.

به همین دلیل است که شما به دستورالعمل noindex نیاز دارید. با دستورالعمل Disallow کار می کند تا مطمئن شوید ربات ها از صفحات خاصی بازدید نمیکنند و یا آن ها را ایندکس نمی کنند.

اگر صفحاتی دارید که نمیخواهید ایندکس شوند (مانند صفحات تشکر)، میتوانید از دستورالعملهای Disallow و Noindex استفاده کنید:

اکنون، آن صفحه در SERP یا نتایج جستجو نشان داده نمی شود.

در نهایت، دستورالعمل nofollow وجود دارد. این در واقع همان لینک nofollow است. به طور خلاصه، به رباتهای وب میگوید که پیوندهای یک صفحه را مورد خزش قرار ندهند.

اما دستور nofollow قرار است کمی متفاوت اجرا شود زیرا در واقع بخشی از فایل robots.txt نیست.

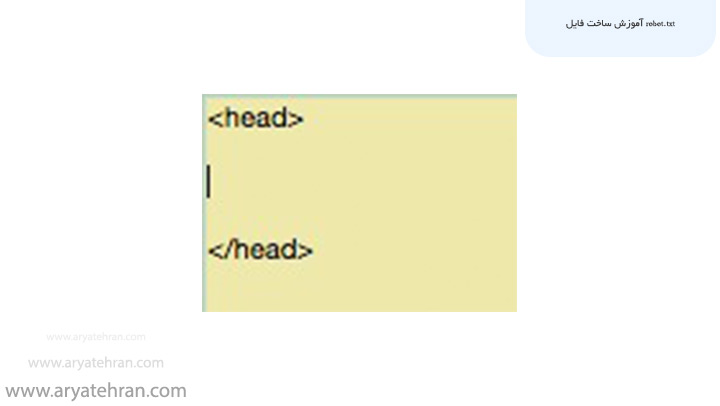

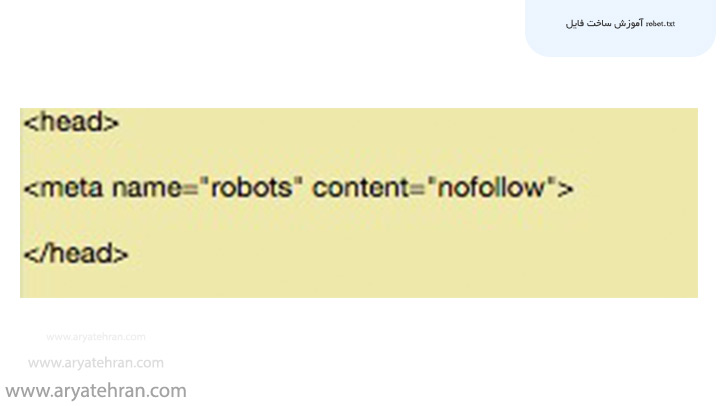

کد صفحه ای را که می خواهید تغییر دهید پیدا کنید و مطمئن شوید که این کد بین تگ های <head> قرار دارد.

سپس این خط را بنویسید:

<meta name=”robots” content=”nofollow”>

اگر می خواهید هر دو دستورالعمل noindex و nofollow را اضافه کنید، از این خط کد استفاده کنید:

<meta name=”robots” content=”noindex,nofollow”>

این به ربات های وب هر دو دستورالعمل را در یک زمان می دهد.

اگر میخواهید با صفر تا صد سئو آشنا شوید و به راحتی این اصول را در سایت تان پیاده سازی کنید و به رتبه های برتر گوگل دست یابید حتما به صفحه آموزش صفر تا صد سئو رایگان مراجعه کنید و این راهکار ها را در سایت تان پیاده سازی کنید.

آموزش ساخت robots.txt وردپرس

آموزش ساخت robots.txt وردپرس مانند دستورایت است که در قسمت قبل به شما اموزش دادیم و شما میتوانید از این دستورات برای سایت های وردپرسی نیز استفاده کنید.

البته شما میتوانید از افزونه All in One SEO برای ساخت robots.txt وردپرس استفاده کنید که شما میتوانید با استفاده از این افزونه ساخت فایل robot.txt را به راحتی انجام داده و برای ویرایش robots.txt اقدام کنید.

برای ویرایش robots.txt شما باید در منو پیشخوان وردپرس روی گزینه All in One SEO کلیک گنید و از میان گزینه های نمایش داده شده گزینه Enable Custom Robots.txt را انتخاب کنید. به این ترتیب شما میتوانید به این فایل دسترسی داشته باشید و برای ویرایش robots.txt اقدام کنید.

به این ترتیب شما میتوانید در بخش Robots.txt Preview به این فایل دسترسی داشته باشید و دستورات قرارداده شده در این فایل را ویرایش کنید.

در این بخش دکمه Add Rule وجود دارد که میتوانید با استفاده از این دکمه دستورات یا قوانین سفارشی خود را به فایل تان اضافه کنید.

از ایندکس شدن چه صفحاتی باید جلوگیری شود

یکی ازسوالاتی که برای سئوکاران مطرح میشود این است که چه صفحاتی باید ایندکس شوند و از ایندکس شدن چه صفحاتی باید جلوگیری شود؟

شما با استفاده از فایل robots.txt میتوانید جلوی ایندکس شدن بسیاری از تگ ها، دسته بندی ها و صفحات خاصی از سایت تان را بگیرید زیرا بعضی از موارد میتوانند تاثیر منفی بر رتبه بندی سایت داشته باشند. مواردی که باید برای ایندکس شدن آن ها جلوگیری کرد عبارتند از:

- صفحات با محتوای تکراری

- صفحاتی که با هم تداخل دارند و تعدادی از آن ها از نظر ورودی ارزشی ندارند.

- تگ ها و برچسب هایی در سایت که به عنوان محتوای اضافی در سایت محسوب میشوند.

- فیلتر بندی های سایت های فروشگاهی که میتوانند مواردی مانند رنگ و قیمت را فیلتربندی کنند.

- صفحات چت و گفتگو در سایت

- صفحات مربوط به پروفایل های کاربران

- صفات ادمین سایت

- به طور کلی فایل هایی که نیازی به دیده شدن توسط گوگل ندارند.

نحوه تغییر فایل robots.txt چیست

یکی از مهمترین عواملی که شما باید برای تغییر فایل robots.txt در نظر داشته باشید سیستم مورد استفاده شما یا cms میباشد. شما در هر cms میتوانید از طریق افزونه ها و یا برنامه ها به فایل robots.txt دسترسی پیدا کنید و تغییرات لازم را در آن اعمال کنید.

برای مثال Wix و Shopify به شما این امکان را میدهد به فایل robots.txt دسترسی پیدا کنید و در سیستم مدیریت محتوا وردپرس نیز مانند Yoast SEO امکان دسترسی به این فایل را ممکن میکند.

در صورتی که از سیستم مدیریت محتوا خاصی استفاده نمیکنید و یا به هر دلیلی نمیخواهید از طریق افزونه ها به آن دسترسی پیدا کنید میتوانید آدرس domain.com/robots.txt را وارد کرده و با نمایش داده شدن فایل آن را ذخیره کرده و یا کپی نمایید.

زمانی که شما robots.txt را دانلود کردید میتوانید در یک نرم افزار ویرایشگر آن را ادیت کنید و تغییرات لازم را در آن اعمال کنید. برای تغییر فایل robots.txt دقت داشته باشید که ویرایشگر شما در استاندارد UTF-8 باشد و نام فایل حتما robots.txt باشد.

بعد از آن که تغییرات را در آن اعمال کردید باید مجدد آن را آپلود نمایید که برای این کار مجدد میتوانید از افزونه های مخصوص cms خودتان و یا هاست و یا از طریق پروتکل های FTP به سرور دسترسی پیدا کنید.

در صورتی که میخواهید robots.txt سایت شما سریع تر مورد بررسی ربات های موتور جستجو قرار بگیرد میتوانید از این لینک برای این کار اقدام کنید.

سینتکس Robots.txt

به طور کلی فایل Robots.txt از بلوک های متنی ساخته شده است که در ان قوانین و دستورالعمل هایی وجود دارد و هر بلوک نوشته در آن با User-agent شروع میشود. نمونه سینتکس Robots.txt در این قسمت برای شما عزیزان قرار داده شده است:

User-agent: * Disallow: /admin/ Disallow: /users/ #specific instructions for Googlebot User-agent: Googlebot Allow: /wp-admin/ Disallow: /users/ #specific instructions for Bingbot User-agent: Bingbot Disallow: /admin/ Disallow: /users/ Disallow:/not-for-Bingbot/ Crawl-delay: 10 Sitemap: https://www.example.com/sitemap.xml

جمعبندی

در این مقاله توضیح دادیم فایل Robots.txt چیست و چطور یک فایل Robots عالی بسازیم و آموزش ساخت فایل robots.txt در وردپرس را به همراه آموزش کامل بهینه سازی فایل Robot.txt برای شما عزیزان قرار دادیم. اگر سوالی در مورد آموزش ساخت robots.txt حرفه ای دارید میتوانید در بخش نطرات سوال تان را مطرح کنید تا اساتید ما در کوتاهترین زمان پاسخ شما را بدهند.

اگر میخواهید سایت تان در کوتاهترین زمان به رتبه های برتر گوگل برسد و بیشترین حجم ترافیک را به سایت هدایت کند میتوانید از خدمات سئو سایت شرکت سئو آریا تهران بهره مند شوید. برای بهره مندی از مشاوره رایگان و کسب اطلاعات بیشتر میتوانید با همکاران ما تماس بگیرید.

سوالات متداول

فایل robots.txt قراردادی است برای جلوگیری از دسترسی خزنده های وب به تمام یا بخشی از یک وب سایت ساخته میشود. این یک فایل متنی با فرمت .txt است که برای SEO استفاده می شود و حاوی دستوراتی برای ربات های موتورهای جستجو است که صفحاتی را مشخص می کند که می توانند یا نمی توانند ایندکس شوند.

در این مقاله به طور کامل معرفی و نحوه ساخت فایل Robots.txt را توضیح دادیم و آموزش کامل بهینه سازی فایل Robot.txt را در این صفحه قرار دادیم.

هیچ دیدگاهی برای این محصول نوشته نشده است.